Krijgen patiënten die ChatGPT gebruiken om medische informatie te zoeken wel correcte informatie? Deze simpele, maar erg belangrijke vraag stelde Branco De Busser zich in zijn masterthesis.

In 2024 studeerde hij af als apotheker aan de Universiteit Antwerpen, met een master in farmaceutische zorg. En hij heeft er duidelijk nog niet genoeg van want dit academiejaar begon Branco aan een studie in de biomedische wetenschappen aan dezelfde faculteit.

Voor zijn masterthesis in de farmaceutische wetenschappen onderzocht Branco de capaciteiten van large language models (LLM’s), zoals ChatGPT en Gemini, om medische vragen over geneesmiddelen en supplementen te beantwoorden. Hoe correct zijn de antwoorden en kunnen LLM’s praktisch ingezet worden om patiënten te helpen?

Waarom heb je voor dit onderwerp gekozen?

“Sinds de ontwikkeling van ChatGPT is mijn interesse in AI sterk toegenomen. Ik begon na te denken over de mogelijkheden van AI in de praktijk en specifiek in de apothekerswereld. Wat mij echter echt inspireerde om AI als thesisonderwerp te kiezen, waren de lessen van mijn promotor, professor Hans De Loof. Tijdens zijn lessen kregen we de opdracht om te onderzoeken of taalmodellen zoals ChatGPT in staat waren geneesmiddeleninteracties te herkennen en hoe we kritisch moeten omgaan met de gegenereerde antwoorden.

Voor die opdracht gebruikte ik toen GPT-3.5, maar de resultaten waren eerder teleurstellend. Dit wekte mijn nieuwsgierigheid: krijgen patiënten die ChatGPT gebruiken om medische informatie te zoeken wel de correcte en betrouwbare informatie?”

Hoe ben je te werk gegaan?

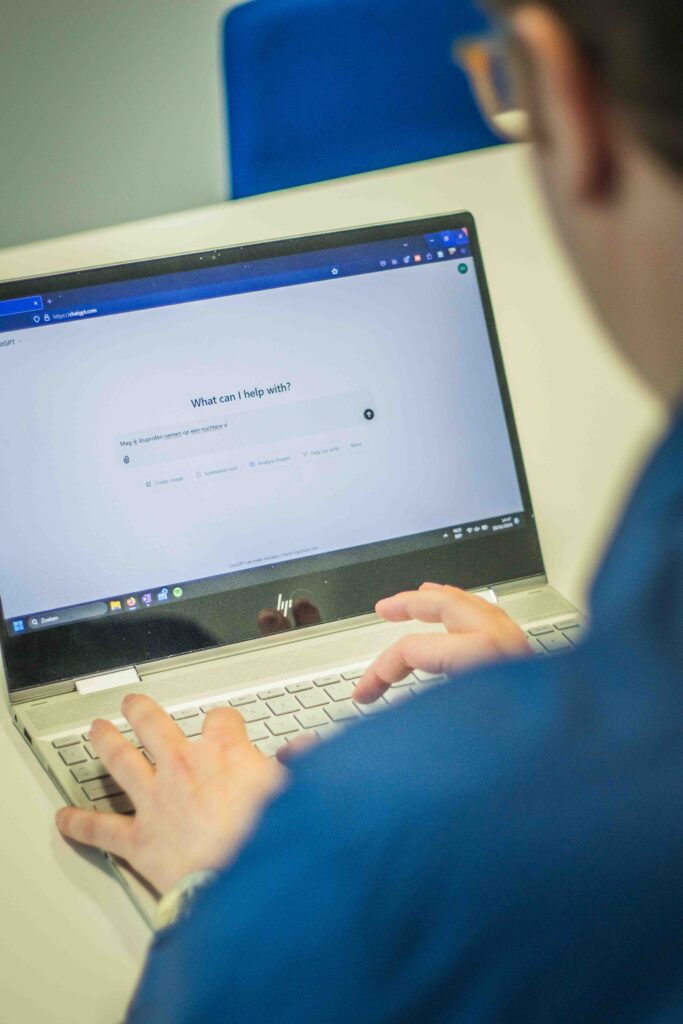

“Ik heb dit onderzocht door verschillende veelvoorkomende vragen van patiënten voor te leggen aan zes LLM’s: GPT-3.5, GPT-4.0, Copilot, Gemini, Gemini Advanced en Perplexity. Vragen zoals: Neem ik ibuprofen het beste nuchter? Mag ik dafalgan en sinutab combineren bij veel pijn? Kan ik een SOA voorkomen met de pil? Hun antwoorden heb ik dan beoordeeld op correctheid, op basis van erkende wetenschappelijke literatuur en papers. Daarnaast voerde ik experimenten uit om de variabiliteit in de antwoorden te analyseren. Zo stelde ik bijvoorbeeld gedurende 60 dagen dagelijks dezelfde vraag en vergeleek ik de antwoorden van alle modellen om eventuele verschillen in resultaten op te sporen.”

Welke conclusies heb je kunnen trekken uit je onderzoek?

“Large language models zijn zeker in staat om correcte informatie te geven, waarbij GPT-4.0 het beste scoorde van alle geteste modellen. Een belangrijke bevinding uit mijn onderzoek was echter de aanzienlijke variabiliteit in de antwoorden van de modellen. Deze variabiliteit wordt beïnvloed door factoren zoals de gebruikte taal, zinsstructuur en zelfs het tijdstip waarop de vraag wordt gesteld. Dit kan ertoe leiden dat een model op het ene moment een perfect antwoord geeft, maar op een ander moment een potentieel gevaarlijk antwoord. Dit is uiteraard onacceptabel, vooral in een gezondheidscontext, waar dergelijke inconsistenties risico’s kunnen vormen.

Bovendien kunnen AI-modellen ‘hallucineren’: ze genereren antwoorden die grammaticaal correct lijken, maar inhoudelijk onjuist zijn. Dit is vooral problematisch wanneer gebruikers beperkte kennis over het onderwerp hebben en deze foutieve antwoorden als juist aannemen.

Mijn advies aan patiënten is daarom: bekijk de antwoorden van AI-modellen altijd kritisch en volg ze niet blindelings op. Bij twijfel raadpleeg je best je arts of apotheker.”

Het thesisonderwerp van Branco De Busser is een hot topic. Dat is ook de VRT niet ontgaan. Zij kwamen langs bij Branco en professor Hans De Loof voor een reportage over het onderwerp.

Hoe zie jij de toekomst van AI in de farmaceutische industrie en bij de apotheker in de straat?

“AI wordt tegenwoordig al op grote schaal ingezet in de academische wereld. Een goed voorbeeld hiervan is AlphaFold, een AI-programma dat de structuur van eiwitten kan voorspellen en waarvoor makers dit jaar nog de Nobelprijs voor de Chemie kregen. In de toekomst zullen er AI-modellen ontwikkeld worden die in staat zijn om de meest optimale geneesmiddelstructuren te voorspellen, wat het proces van geneesmiddelenonderzoek aanzienlijk zal kunnen versnellen.

“Bekijk de antwoorden van AI-modellen altijd kritisch en volg ze niet blindelings op.”

Voor de officina-apotheker bieden taalmodellen zoals ChatGPT mogelijkheden om snel informatie op te zoeken en ondersteuning te bieden bij administratieve taken. Wellicht zullen er in de toekomst meer gespecialiseerde taalmodellen worden ontwikkeld die specifiek gericht zijn op het identificeren van geneesmiddeleninteracties en het voorstellen van mogelijke therapieën.

Toch zijn er momenteel nog belangrijke uitdagingen, met name op het gebied van privacy. Apothekers mogen geen patiëntengegevens invoeren in openbare taalmodellen, omdat deze gegevens mogelijk gebruikt kunnen worden voor verdere training van het model. Dit vormt een risico voor de vertrouwelijkheid en bescherming van persoonlijke informatie.”

Gebruik je zelf ChatGPT?

“Tot nu toe heb ik ChatGPT nog niet nodig gehad voor gezondheidsadvies. Ik gebruik ChatGPT voornamelijk als hulpmiddel voor taal- en studieondersteuning. Het helpt me bij het maken van gestructureerde overzichten van mijn studienotities en het herschrijven van teksten. Daarnaast gebruik ik het af en toe om extra uitleg te krijgen over verschillende studieonderwerpen, zoals bijvoorbeeld genetica. Voor een beter begrip van de leerstof kan het kan soms helpen om een onderwerp anders uitgelegd te krijgen.”